AI-baserade rekommendationssystem används i många av de onlinetjänster vi använder idag, inklusive sökmotorer, näthandelsplatser, streamingtjänster och sociala medier.

AI-systemens växande inflytande över vad människor ser och gör på internet har dock skapat oro kring dess mottaglighet för olika typer av missbruk, som t ex aktiv användning för att sprida desinformation och främja konspirationsteorier.

Andy Patel, forskare vid IT-säkerhetsleverantören F-Secures Artificial Intelligence Center of Excellence, genomförde nyligen en serie experiment för att lära sig hur enkla manipulationsmetoder kan påverka AI-baserade rekommendationer på ett socialt nätverk.

Andy Patel

”Twitter och andra nätverk har blivit slagfält där olika människor och grupper lyfter fram olika berättelser. Dessa inkluderar en blandning av organiska konversationer och annonser, men även meddelanden avsedda att undergräva och urholka förtroendet för legitim information,” säger Patel. “Att undersöka hur dessa ’kombattanter’ kan manipulera AI hjälper oss att avslöja gränserna för vad AI realistiskt kan göra och framför allt hur det kan förbättras.”

En PEW Research Center-undersökning*, som genomfördes i slutet av 2020, fann att 53% av amerikanerna får nyheter via sociala medier. Respondenter i åldrarna 18 till 29 år identifierade sociala medier som deras primära nyhetskälla. Samtidigt har forskning tidigare belyst de potentiella riskerna med att förlita sig på sociala medier som en nyhetskälla.

En studie från 2018 visade t ex att de Twitter-inlägg som innehåller falsk information löper 70% större sannolikhet att retweetas.

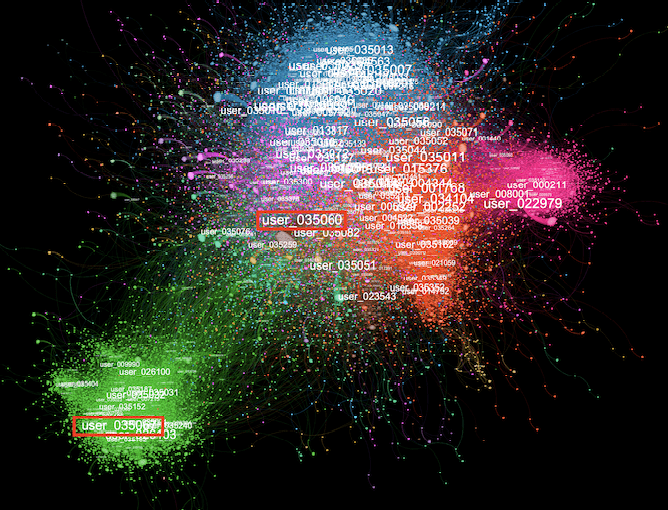

För sin forskning samlade Patel in data från Twitter, som sedan användes för att träna collaborative filtering-modeller (en form av maskininlärning som används för att koda likheter mellan användare och innehåll baserat på tidigare interaktioner) för användning i rekommendationssystem. Därefter utförde han experiment som innebar omskolning av dessa modeller genom att använda datauppsättningar som innehöll ytterligare retweets (och därigenom förgiftade dessa data) mellan utvalda konton för att se hur rekommendationerna förändrades.

Genom att välja ut lämpliga konton att retweeta och variera det antal konton som retweetar, tillsammans med antalet retweets de publicerade, var till och med ett mycket litet antal retweets tillräckligt för att manipulera rekommendationssystemet till att marknadsföra de konton vars innehåll delades via de retweetar som injicerats.

Medan experimenten utfördes med hjälp av förenklade versioner av AI-mekanismer, som sociala medieplattformar och andra webbplatser sannolikt kommer att använda när de förser användarna med rekommendationer, anser Patel att Twitter och många andra populära tjänster redan drabbas av dessa attacker.

”Vi utförde tester mot förenklade modeller för att lära oss mer om hur de verkliga attackerna faktiskt fungerar. Jag tror att sociala medieplattformar redan står inför attacker liknande dem som visas i denna forskning. Men det är svårt för dessa organisationer att vara säkra på att detta är vad som sker, eftersom de bara ser resultatet, inte hur det fungerar,” säger Patel.

Matti Aksela

Enligt F-Secures Vice President of Artificial Intelligence, Matti Aksela, är det viktigt att erkänna och ta itu med de potentiella säkerhetsutmaningarna för AI.

”Då vi förlitar oss mer och mer på AI i framtiden, måste vi även förstå vad vi behöver göra för att skydda det från potentiellt missbruk. Då AI och maskininlärning driver en allt större del av de tjänster vi är beroende av krävs att vi förstår dess säkerhetsstyrkor och svagheter, förutom dess fördelar, så att vi kan lita på resultaten. Säker AI är grunden för pålitlig AI,” säger Aksela.